Tulemuste võrdlus: ligipääsetavuse automatiseeritud vs manuaalne testimine

28.juunist 2025 jõustuvad ligipääsetavuse nõuded sunnivad teenuseomanikke hindama oma digikeskkondade vastavust Euroopa Liidu standardile EN 301 549 V3.2.1. Hindamiseks on kaks võimalust: suhteliselt ressursimahukas manuaaltestimine või atraktiivsed tasuta automatiseeritud testimistööriistad. Selles artiklis uurime, kui suur on erinevus automatiseeritud ja manuaalse ligipääsetavuse testimise tulemuste vahel.

Automatiseeritud testimistööriistad on digikeskkondade ligipääsetavuse kontrollimisel kasulikud ja sobivad esimeseks sammuks probleemi kaardistamisel, kuid nende võimekus on piiratud. Ligipääsetavuses on oluline roll kvaliteetsel tarkvaraarendusel, sest meie audititest on näha, et ligi 75% ligipääsetavuse probleemidest tekivad just front-end koodis. Paraku kõiki neid probleeme automaattestid tuvastada ei suuda.

Automaattööriistad suudavad kontrollida küll mõningate ettemääratud tehniliste tingimuste täitmist (nt kas <input> on seotud <label> elemendiga), kuid ei näe suurt pilti ega suuda mõista koodis tegelikult leiduvaid probleeme (nt kui elemendid on grupeeritud visuaalselt, kuid mitte koodis).

Veel enam – automatiseeritud tööriistad võivad anda ka ekslikke tulemusi, tuues esile probleeme, mida tegelikult ei eksisteeri või vastupidi, jättes olulised vead tuvastamata.

Ligipääsetavus ei ole ainult tehniline nõue, vaid eelkõige inimkeskne lähenemine. Manuaalne testimine on vajalik, et mõista, kuidas veebileht või rakendus tegelikult erinevatele kasutajatele toimib. Manuaalne testimine aitab avastada keerukamaid probleeme ja valideerida automatiseeritud tööriistade leide.

Testimine

Meie soov oli välja selgitada, kui suur on erinevus automatiseeritud ja manuaalse ligipääsetavuse testimise tulemuste vahel. Testimiseks valisime ühe rahvusvahelise avaliku asutuse esilehe. Testisime seda nii automaatsete tööriistade abil kui ka manuaalselt. Automaatseks testimiseks kasutasime tasuta brauseri laiendusi: WAVE Evaluation Tool, AXE DevTools, ARC Toolkit ja Siteimpove Accessibility Checker.

Manuaalse testimise viisime läbi desktop-versioonil kasutades Chrome'i brauserit ja JAWS ekraanilugejat ning mobiiliversioonil iOS-seadmes VoiceOver ekraanilugejaga ning Android-seadmes TalkBack ekraanilugejaga.

Tulemused

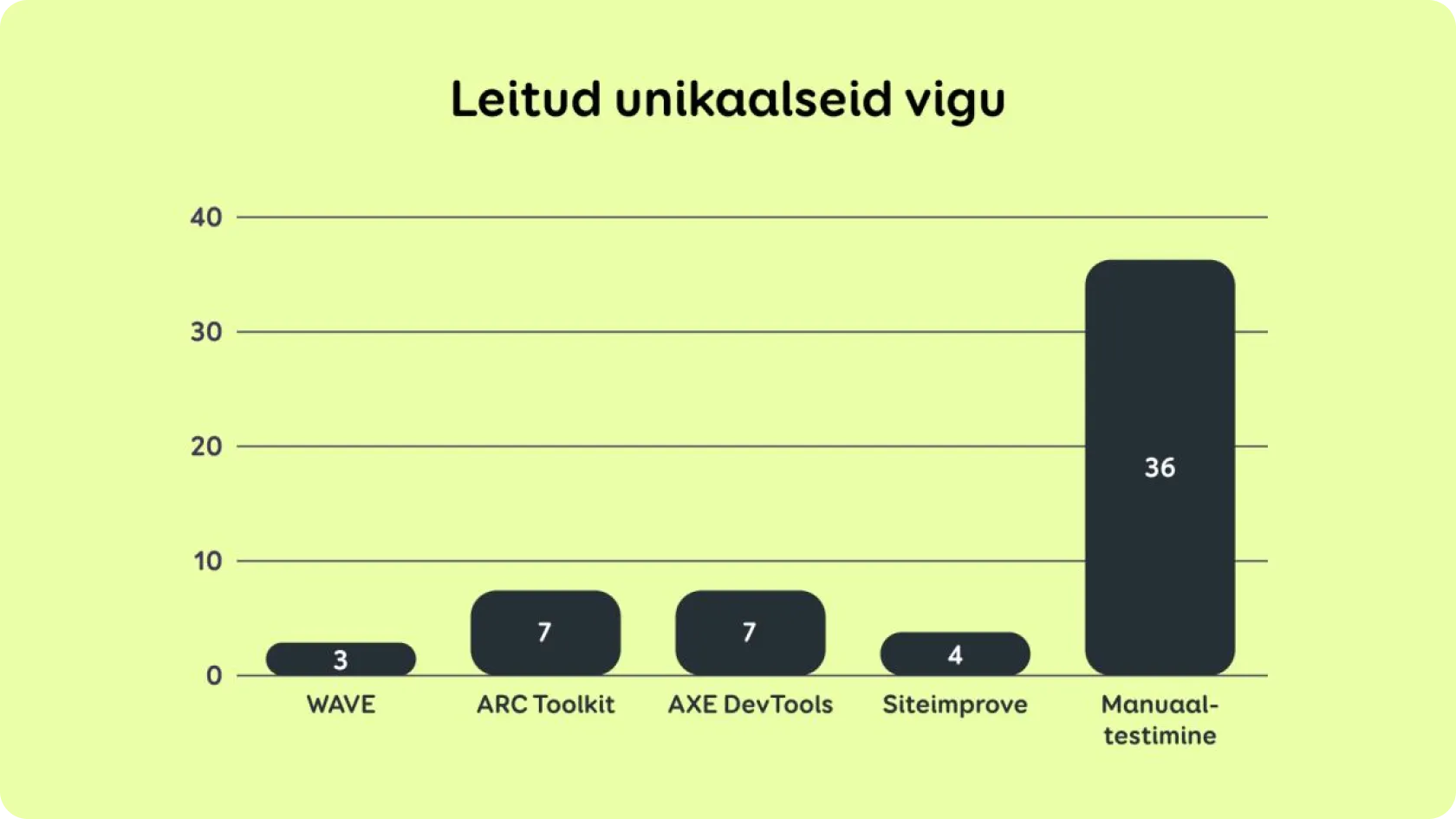

Joonisel 1 esitatud kokkuvõtlikud tulemused näitavad, et automatiseeritud tööriistad tuvastasid oluliselt vähem ligipääsetavuse probleeme kui manuaalne testimine.

Tegelik leidude hulk on aga veelgi väiksem, kuna enamjaolt raporteerivad automaattööriistad sama viga iga koodielemendi kohta eraldi, mis tekitab korduseid. Tabelis 1, kus kuvame tulemusi leidude kaupa, koondasime korduvad leiud üheks, et muuta need võrreldavaks manuaalse testimise tulemustega.

Joonis 1. Leitud vigu kokku.

Näiteks kui automaattööriist tõi välja neli eraldi viga – üks iga ebakorrektse listi elemendi kohta –, siis tabelis 1 on see kuvatud ühe veana „üks list loetakse ekraanilugeja poolt ette nelja eraldi listina“.

Automaattööriistad toovad esile ka valideerimisvigu (parsing errors), kuid manuaaltestimisel neid ei arvestatud, kuna WCAG viimases versioonis 2.2 on “Parsing” punkt eemaldatud ega vaja testimist.

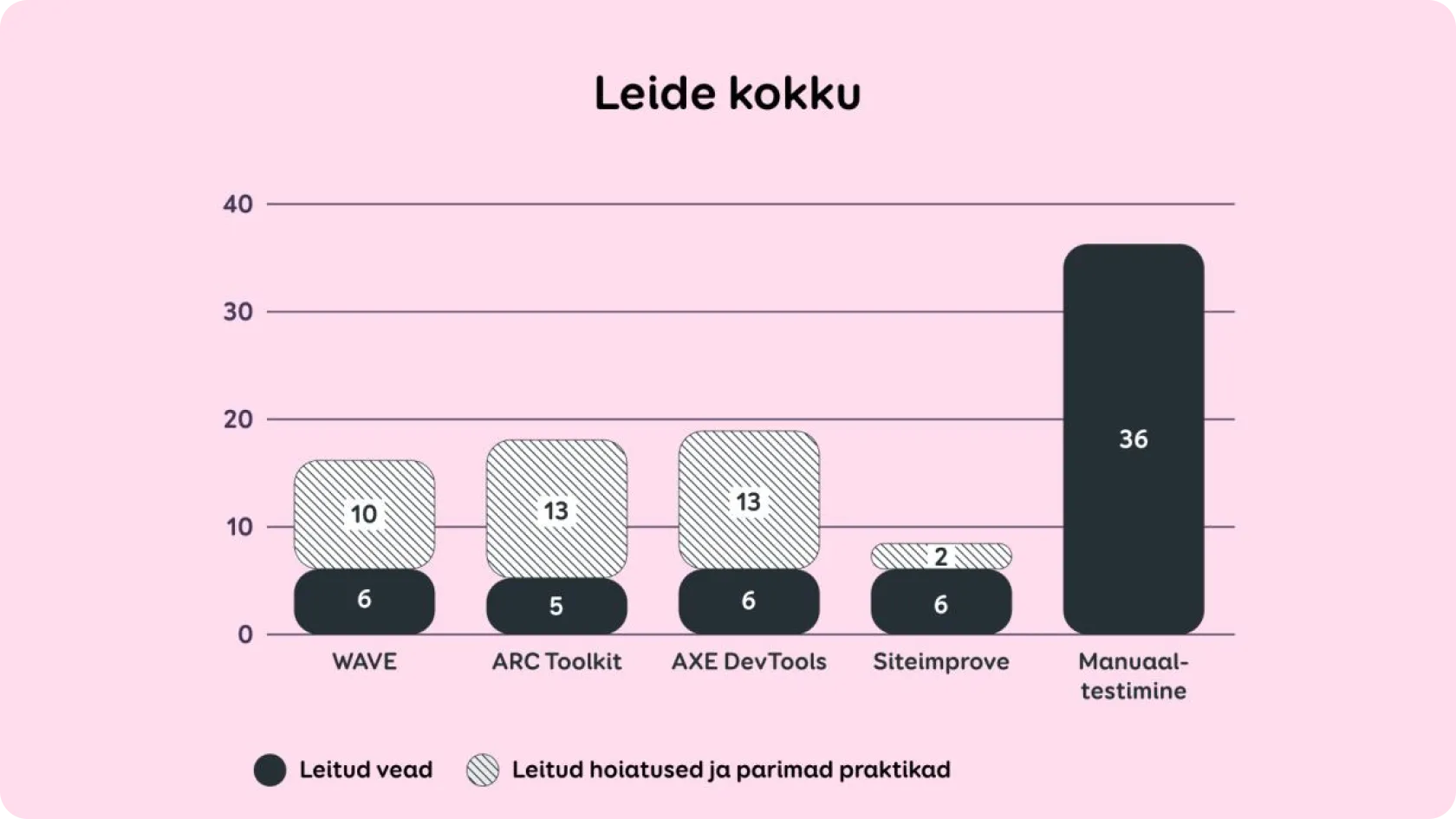

Ka erinevate automaattööriistade tulemused ei ole omavahel täielikult võrreldavad, kuna iga tööriist raporteerib leide erineval viisil. Enamus automaattööriistasid tõid välja ka “hoiatusi ja parimaid praktikaid”.

Nende puhul võib olla ebaselge, kas tegemist on tegeliku ligipääsetavuse reegli rikkumisega või lihtsalt võimalusega kasutajakogemust parandada. Tabelis 1 märkisime „jah“ ka juhul, kui manuaaltestimises märgiti asi veana, kuid automaattööriist paigutas selle “hoiatuste ja parimate praktikate” alla.

See näitab, et kuigi automatiseeritud testid toovad esile erinevaid leide, on nende valideerimiseks siiski vaja ligipääsetavuse alaseid teadmisi ja inimlikku analüüsi. Järgnevas tabelis toome välja kõik manuaaltestimise leiud ning selle, kas automaattestid tuvastasid need või mitte.

Testimise tulemused